Desde el famoso Informe Coleman, de 1966, quedó relativizada la aportación de la escuela (de la actuación docente) para el logro del éxito educativo del alumnado. Se explicaban mucho mejor las diferencias de resultados escolares por el nivel socioeconómico y cultural (origen social) de las familias y, aunque eso no se medía en el estudio, por el potencial intelectual del alumno.

En nuestros días, con el apogeo del Informe PISA, es el ISEC, Índice Socioeconómico y Cultural elaborado a efectos de dicho Informe, el que marca una mayor influencia sobre los resultados educativos, más que cualquier otro factor de recursos, organización escolar o número de horas lectivas.

Pero la “escuela importa”, como sostienen los partidarios de la corriente de “Escuelas Eficaces”. ¿Cuánto importa o cuánto aporta? Pues, menos palabras y más números: hay que medirlo.

Nos interesa tener un indicador fiable, de resultados escolares, que exprese el rendimiento obtenido en un centro educativo. Las calificaciones escolares han de ser la base, y son datos que tienen los propios centros, que para cada grupo de alumnos pueden calcular estadísticas simples y de comparación con grupos paralelos: notas globales, medias aritméticas, medianas, mínimos, máximos, desviación típica, … Las administraciones educativas elaboran tasas: de promoción, de titulación, de idoneidad, de abandono escolar, etc., que pueden servir para poner en relación los datos y tasas de un centro con la media de una zona educativa, de una provincia o de la comunidad autónoma de que se trate.

Hay que destacar que esa comparación de resultados de un centro con una media determinada no es una valoración justa, porque se utilizan los datos brutos de los centros, sin tener en cuenta las características del contexto y del alumnado. Pero no parece que las autoridades educativas tengan clara esa “injusticia”, porque emplean las tasas y comparaciones para determinar, por ejemplo, en qué centros intervenir con tal o cual programa o evaluación, tomando como destinatarios a los centros por debajo de dichas medias o tasas. Un símil para entender lo inadecuado de ese proceder: supongamos que a un grupo de alumnos de edades entre 6 y 12 años los ponemos a correr una vuelta al campo de fútbol, saliendo todos a la vez, y a los dos o tres últimos en llegar se les hará un examen médico para mejorar su condición corredora. ¡Vaya memez!, pensaríamos. Claro que han llegado los últimos los más pequeños, los de 6 años, que pueden estar sanos y bien formados, pero es que se han medido juntos alumnos de diversas edades, en bruto, sin tener en cuenta sus características, principalmente aquí, su edad. Pues eso es lo que se haría al comparar los resultados escolares de un centro de zona socialmente desfavorecida, con los resultados medios, comparación de la que, por el contrario, saldría muy ganador un centro ubicado o receptor de alumnado de nivel social alto. No sería justo comparar la tasa de promoción, o de titulación, de un centro, ni con la media, ni con la de otro centro, aunque sea de la misma zona o de la misma población. Cada centro tiene sus circunstancias y hay que tenerlas en cuenta.

Llegados a este punto anotamos: necesitamos un indicador que mida de forma justa los resultados y no para comparativa con otros centros, sino para evaluar el propio progreso de un centro hacia la mejora, que sirva para tomar decisiones, no para que compitan entre sí. ¿Un indicador, varios indicadores, un indicador agregado? Propongo un solo indicador, por sencillo, representativo y fácil de entender por todos. Algo así como el PIB en economía, el C.I. (Coeficiente Intelectual) en psicología, o el C14 (carbono 14) en paleontología. Pero que, para ser justos, ese indicador de resultados o rendimiento escolar debe tener en cuenta las características del contexto del centro y de su alumnado.

Un solo indicador, al no tener en cuenta otros muchos factores, es imperfecto, solo deja traslucir una parte de la realidad y puede ser cuestionado con facilidad. Ocurre con el PIB, al no incluir factores de sostenibilidad ambiental, o con el C.I. porque no habría una sola inteligencia sino múltiples inteligencias, pero en ambos casos es lo mejor que tenemos, aunque no le concedamos fiabilidad absoluta. Así que, sigamos.

El indicador que nos servirá de base para referenciar el rendimiento de un centro educativo será el porcentaje de alumnado que supera todas las áreas o materias en cada etapa educativa, de momento ceñidos a Primaria y ESO. Es decir, para cada centro de Primaria habría que obtener el porcentaje de alumnado que aprueba todas las áreas (número de alumnos que aprueban todas, dividido por el número total de alumnos en la etapa, multiplicado por 100 para que sea un porcentaje). Y en los centros que imparten ESO se obtendría igualmente el porcentaje: alumnado que aprueba todas las materias en todos los cursos, dividido por el número total de alumnos en la etapa, y por 100.

Ya tenemos un porcentaje, un solo dato, que nos refiere, digamos, el tanto por ciento del alumnado del centro que cursa con éxito el currículo que le corresponde. Supongamos un 76%. O puede ser un 49%. Este dato puede calcularlo el propio centro, ya que dispone de las calificaciones de todos sus alumnos. Sería el Valor Real (VR) de alumnado que aprueba todas las asignaturas (áreas en Primaria, materias en ESO). Al unir en un solo dato el rendimiento del centro para una etapa puede pensarse que simplificamos mucho, pero con ello obviamos los altibajos que suelen darse de una promoción de alumnos a otra, diferencias que se compensan al unir todos los resultados en un solo valor para el centro.

Hasta aquí nada que no se sepa, y seguimos con datos brutos, que nada saben del contexto del centro y de las características del alumnado. Si un centro obtiene un 58%, ¿es poco, está bien, es mucho? Depende. Tenemos que saber y valorar cuantitativamente, el entorno sociocultural y económico del centro y las características de su alumnado, que representaremos por el ISC y el INEAE, respectivamente.

El ISC es el Indicador Socioeconómico y Cultural que elabora la consejería competente en materia de educación (estamos en Andalucía), un índice que va del 1 al 10. El INEAE va a ser el porcentaje de alumnado de NEAE matriculado en la etapa que se considere, obteniéndolo por división del número de alumnado NEE+DIA+DES (exceptuado el de aula específica de Educación Especial) entre el total de alumnado de la etapa (también exceptuado el de aula específica de Educación Especial). Un simple cálculo de la correlación nos dice cómo se relacionan estas variables o índices, con los resultados: correlación positiva con el ISC: a mayor nivel de este índice, mejores resultados; y negativa con el INEAE: a mayor porcentaje de este alumnado, menores resultados.

Para ponderar el valor bruto del porcentaje de alumnado que aprueba todas las áreas/materias (VR), vamos a tener en cuenta su ISC y su INEAE. Esto se está haciendo en la provincia de Cádiz desde hace varios años, en el seno de las Comisiones de Trabajo de los Rendimientos Escolares, pertenecientes a las Zonas Educativas (hay cuatro en la provincia). Dicha Comisión dispone de los datos que interesan a este respecto: VR, ISC e INEAE de cada centro que imparte Primaria y ESO, públicos y concertados. Piénsese en una tabla en la que en cada fila hay un nombre de centro, código y localidad, más tres valores numéricos, uno es el porcentaje de su alumnado que aprueba todas las asignaturas (VR), otro es el índice socioeconómico y cultural (ISC) que ha obtenido la Consejería para ese centro, y el tercero es el porcentaje de alumnado NEAE del centro (INEAE).

Cuando hay solo dos variables la representación gráfica de sus valores en un diagrama de puntos (dispersión) nos da una nube de puntos con una forma más o menos definida. Mediante el análisis de regresión (procedimiento estadístico) podemos obtener la ecuación de la recta que mejor se adapte a dicha nube de puntos. El análisis de regresión logra que la suma de las distancias punto-recta (al cuadrado, para que no se compensen entre sí) sea mínima. Con la ecuación obtenida podemos calcular para cada valor de la variable independiente, el que corresponde a la variable dependiente.

En el estudio de las Comisiones de Rendimientos se manejan tres variables (VR, ISC, INEAE) por lo que la nube de puntos se dispersa en unos ejes tridimensionales y puede representarse por un plano que haga mínimas la suma de las distancias cuadráticas de cada punto al plano. Eso es lo que hace el análisis de regresión, con el que obtenemos la ecuación de 2 variables independientes (ISC e INEAE) y una variable dependiente (VR), algo como lo siguiente:

VE = a + b∙ISC + c∙INEAE (los valores de los coeficientes a, b, y c, nos lo da el análisis de regresión)

Por ejemplo, obtenemos: VE = 67,2 + 1,4∙ISC – O,4∙INEAE

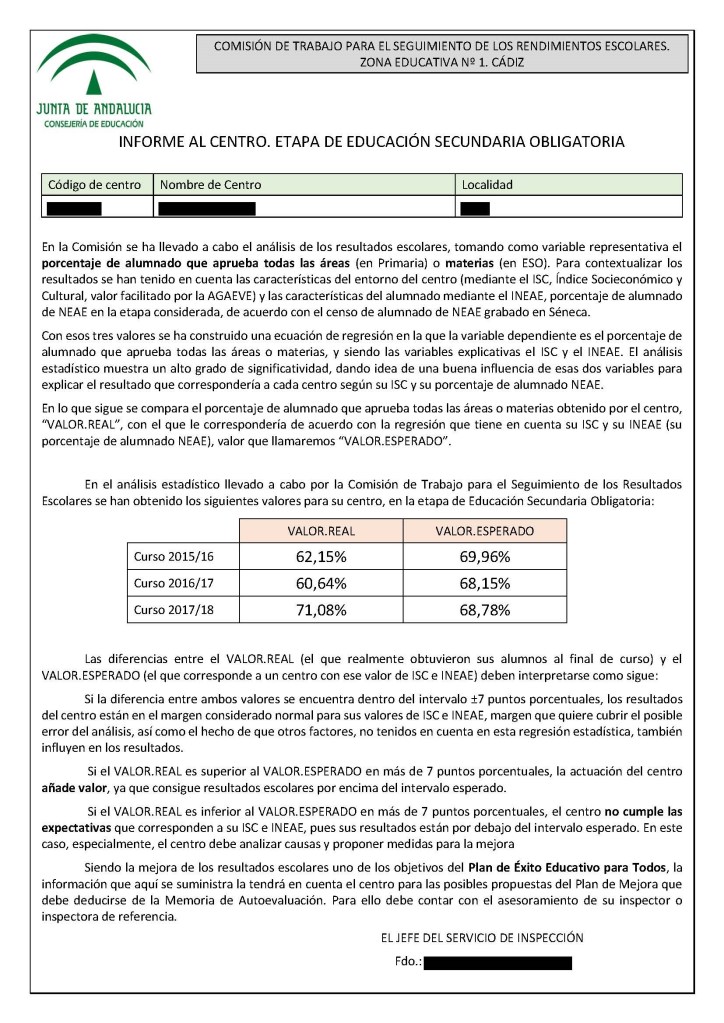

| VALOR.REAL | VALOR.ESPERADO | |

| Curso 2015/16 | 76,41% | 66,54% |

| Curso 2016/17 | 73,55% | 65,13% |

| Curso 2017/18 | 72,76% | 63,18% |

Con esa fórmula (es la ecuación de la regresión efectuada), sustituyendo en ella los valores de ISC e INEAE de un centro podemos saber qué valor del porcentaje de alumnado que aprueba todas las asignaturas le correspondería. Por eso lo llamamos VE, Valor Esperado. O sea, con esa fórmula o ecuación si vamos poniendo los valores ISC e INEAE de los centros tendremos el valor que corresponde a cada centro en función de las características de su contexto (ISC) y de las características de su alumnado (INEAE). Ese porcentaje, VE, obtenido para cada centro, ya no es un valor bruto, ya tiene en cuenta la influencia de las dos variables que se han revelado como más significativas para explicar los resultados escolares, el ISC y el INEAE.

Teníamos el Valor Real, VR, del porcentaje de alumnado que aprueba todas en cada centro, y el análisis de regresión nos ha dado el Valor Esperado, VE, que corresponde a cada centro en función de sus características. Si el Valor Real, el que obtuvieron los alumnos, está por encima del Valor Esperado, que es el que corresponde al centro por su entorno y alumnos, podemos decir que la actuación del centro añade valor, mientras que si VR < VE, la actuación del centro, su rendimiento, no alcanza las expectativas.

Pero como el análisis estadístico es de términos probabilísticos, hay que dejar un intervalo para margen de error. Ese intervalo lo hemos fijado en Cádiz en ±5 puntos porcentuales para Primaria y ±7 puntos porcentuales en ESO (en ESO los resultados reales presentan mayor desviación típica), de modo que el informe de resultados facilitado a cada centro, relativo a los tres últimos cursos:

| VALOR.REAL | VALOR.ESPERADO | |

| Curso 2015/16 | 82,82% | 86,37% |

| Curso 2016/17 | 84,38% | 87,12% |

| Curso 2017/18 | 75,63% | 87,57% |

En el caso de este centro, de Primaria, la diferencia VR – VE se mueve en el intervalo de indecisión o casi equivalencia, en los dos primeros cursos, mientras que en el 2017/18 son inferiores en más de 5 puntos, no alcanza las expectativas y debe pensar en un plan de mejora de su rendimiento.

Este otro centro, de Secundaria, presenta valores reales siempre por encima de lo que le corresponde por su entorno y alumnado, lo está haciendo bien, su rendimiento es positivo.

Así que ya tenemos un indicador de Rendimiento de los centros educativos utilizando el Valor Esperado, VE, que lo referencia solo consigo mismo, con sus valores de ISC e INEAE, y es una información clara para saber si su rendimiento (diferencia VR – VE) es el adecuado o debe ponerse manos a la mejora, sin excusas porque la zona en la que está el centro es desfavorecida (se ha tenido en cuenta en su ISC) o porque tiene mucho alumnado NEAE (también se ha tenido en cuenta).

Con esos datos (VR y VE) que facilitamos a los centros en un informe individualizado (cada centro solo conoce sus datos) le proporcionamos una información, y una valoración, general pero justa en cuanto que se han tenido en cuenta los dos factores más significativos a la hora de explicar los resultados escolares, para que sea el propio centro el que lleve el proceso de reflexión y, en caso necesario, de mejora. Si un centro recibe que su VR está por debajo de su Valor Esperado, recibe en realidad el mensaje de que “su rendimiento no está siendo adecuado a las circunstancias del cen tro”, y aunque se le dé solo un valor global, el centro tiene los datos de sus resultados o calificaciones, y puede profundizar buscando dónde (en qué cursos o grupos) han sido más bajos los resultados, analizando causas y tratando de poner en marcha medidas que los mejoren.

Sin tener que mirar medias estadísticas o resultados en otros centros o zonas, porque con mirarse a sí mismo tendrá suficiente.